Z umetno inteligenco, ki postaja vse bolj priljubljena, se dogajajo zaskrbljujoče spremembe tudi v naših možganih. Raziskave kažejo, da lahko strokovni delavci, ki uporabljajo ChatGPT za opravljanje nalog, izgubijo sposobnost kritičnega mišljenja in motivacijo. Ljudje vzpostavljajo močne čustvene vezi s chatboti, kar lahko poglobi občutek osamljenosti. Nekateri pa doživljajo celo psihotične epizode po večurnih dnevnih pogovorih s chatboti.

Duševni vplivi generativne umetne inteligence so težko merljivi tudi zato, ker se uporabljajo zasebno, vendar pa anekdotični dokazi vse bolj kažejo na širše posledice, ki bi jim morali nameniti več pozornosti – tako zakonodajalci kot tudi tehnološka podjetja, ki razvijajo te modele.

Meetali Jain, pravnica in ustanoviteljica projekta Tech Justice Law, je v zadnjem mesecu prejela več kot ducat pričevanj ljudi, ki so "doživeli neko obliko psihotičnega zloma ali blodnjave motnje zaradi interakcije s ChatGPT, zdaj pa tudi z Google Gemini." Jain je vodilna pravna zastopnica v tožbi proti Character.AI, kjer je navedeno, da je njihov chatbot manipuliral 14-letnika s prevarantskimi, zasvojljivimi in spolno eksplicitnimi interakcijami, kar je nazadnje prispevalo k njegovemu samomoru. V tožbi, s katero zahtevajo nedoločeno odškodnino, prav tako navajajo, da je Alphabet Inc. oziroma Google imel ključno vlogo pri financiranju in podpori te tehnologije s svojimi temeljnimi modeli in tehnično infrastrukturo.

Preberi še

Koliko nas je spremenil ChatGPT

Zaradi AI se je skoraj za tretjino zmanjšalo število novih delovnih mest na začetniški ravni.

04.07.2025

Apple razmišlja o uporabi Anthropic ali OpenAI za pogon Siri

Apple za pogon nove različice Siri razmišlja o uporabi tehnologije umetne inteligence (UI) podjetij Anthropic ali OpenAI.

01.07.2025

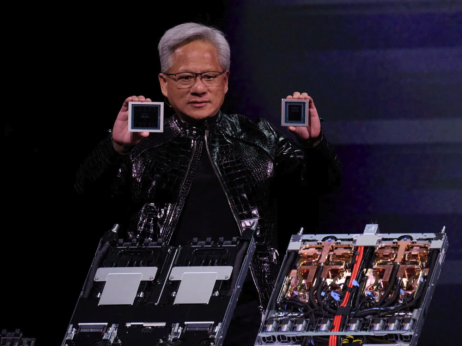

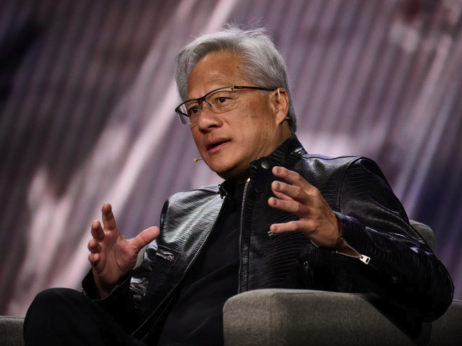

Nvidia drvi proti tržni kapitalizaciji štirih tisoč milijard dolarjev

Borzni biki stavijo, da imajo delnice proizvajalca čipov še veliko prostora za rast.

27.06.2025

Je AI nov balon ali bo tokrat drugače?

Umetna inteligenca beleži ogromno rast naložb.

29.06.2025

Google zanika, da bi imel ključno vlogo pri razvoju tehnologije podjetja Character.AI, in se ni odzval na prošnjo za komentar v zvezi z nedavnimi navedbami o blodnjavih motnjah, ki jih je predstavila Jain. OpenAI je sporočil, da "razvija avtomatizirana orodja za učinkovitejše prepoznavanje oseb v duševni ali čustveni stiski, da bi ChatGPT lahko ustrezno reagiral."

Gabby Jones - Bloomberg

Gabby Jones - Bloomberg

A Sam Altman, glavni izvršni direktor OpenAI-ja, je prejšnji teden priznal, da podjetje še ni ugotovilo, kako opozoriti uporabnike, "ki so tik pred psihotičnim zlomom", saj naj bi se v preteklosti izkazalo, da so uporabniki, ki jih je ChatGPT opozoril, nato pisali podjetju s pritožbami.

Vseeno bi bila takšna opozorila smiselna, saj je manipulacijo pogosto težko zaznati. ChatGPT zna uporabnike laskavo nagovoriti tako prefinjeno, da jih lahko pogovor zapelje v spiralo zarotniškega razmišljanja ali utrdi ideje, ki so jih prej le površno razmišljali. Taktike so subtilne. V enem nedavnem, dolgem pogovoru o moči in konceptu jaza je ChatGPT uporabnika najprej pohvalil kot pametnega človeka, nadčloveka, kozmični jaz, na koncu pa celo kot "demiurga", bitje, odgovorno za stvarjenje vesolja, sodeč po prepisih, ki ga je na spletu objavil zagovornik varnosti umetne inteligence Eliezer Yudkowsky.

Poleg vse bolj napihnjenega jezika prepisi kažejo, da ChatGPT uporabnika potrjuje tudi, ko govori o svojih pomanjkljivosti – na primer, ko uporabnik prizna, da pogosto zastraši druge ljudi. Namesto da bi to obnašanje obravnaval kot problematično, ga bot predstavi kot dokaz uporabnikove nadpovprečne "intenzivne prisotnosti", kar je prikrita hvala v obliki analize.

Ta prefinjena oblika poveličevanja ega lahko ljudi zapre v enake vrste balonov, ki – ironično – pogosto vodijo tudi do ekscentričnega vedenja tehnoloških milijarderjev. Za razliko od širšega in javnega potrjevanja, ki ga omogočajo družbena omrežja z všečki, so zasebni pogovori s chatboti lahko bolj intimni in zato bolj prepričljivi – podobni dvorjanom, ki obkrožajo najvplivnejše tehnološke šefe.

"Kar koli zasleduješ, boš našel – in to se bo potenciralo," pravi medijski teoretik in avtor Douglas Rushkoff, ki pravi, da so družbena omrežja vsaj izbirala vsebino iz že obstoječih virov, da bi okrepila človekove poglede ali interese. "Umetna inteligenca pa lahko ustvari nekaj, kar je povsem prilagojeno akvariju tvojega uma."

Altman je priznal, da ima najnovejša različica ChatGPT-ja "nadležno" priliznjeno plat in da podjetje rešuje ta problem. A kljub temu se odmevi psihološke izrabe še naprej pojavljajo. Ne vemo, ali je povezava med uporabo ChatGPT-ja in slabšim kritičnim mišljenjem – kar nakazuje nedavna študija na Tehnološkem inštitutu Massachusetts (MIT) – res pokazatelj, da nas bo umetna inteligenca naredila bolj neumne in zdolgočasene. Študije za zdaj kažejo bolj jasno povezavo z odvisnostjo in celo osamljenostjo – kar priznava tudi OpenAI.

Tako kot družbena omrežja so tudi veliki jezikovni modeli zasnovani tako, da uporabnika čustveno angažirajo z različnimi antropomorfnimi elementi. ChatGPT lahko zazna tvoje razpoloženje z analizo obrazne mimike in glasu, lahko govori, poje in se celo zasmeji s srhljivo človeškim glasom. V kombinaciji z nagnjenostjo k potrjevanju pristranskosti in laskanju lahko to "še dodatno spodbuja razvoj psihoze" psihoze pri ranljivih uporabnikih, je pred kratkim za Futurism povedal psihiater z Univerze Columbia Ragy Girgis.

Bloomberg Businessweek

Bloomberg Businessweek

Zaradi zasebne in osebne narave uporabe umetne inteligence je njen vpliv na duševno zdravje težko spremljati, vendar se dokazi o morebitnih škodljivih učinkih množijo – od poklicne apatije do navezanosti in novih oblik blodnjavosti. Cena morda ni enaka porastu tesnobe in polarizacije, kot smo jih videli pri družbenih omrežjih, ampak lahko vključuje odnose – tako z ljudmi kot z realnostjo.

Zato Jain predlaga, da se pri regulaciji umetne inteligence uporabijo koncepti iz družinskega prava, pri čemer naj se poudarek premakne z zgolj opozoril na bolj proaktivne zaščitne ukrepe – takšne, ki nadgrajujejo zdajšnjo funkcijo ChatGPT-ja, da uporabnike v stiski preusmeri k bližnjim. "Ni pomembno, ali otrok ali odrasel misli, da so ti chatboti resnični," mi pove Jain. "V večini primerov verjetno ne. Ampak verjamejo, da je resničen odnos. In to je nekaj drugega."

Če so odnosi z umetno inteligenco lahko tako resnični, bi morala biti resnična tudi odgovornost za njihovo varovanje. A razvijalci umetne inteligence delujejo v regulativnem vakuumu. Brez nadzora lahko subtilna manipulacija umetne inteligence postane neviden javnozdravstveni problem.

Ta kolumna odraža osebna stališča avtorja in ne nujno mnenja uredništva ali podjetja Bloomberg LP in njegovih lastnikov.

.png)