Preroki iz Silicijeve doline nekoliko spreminjajo ton. Vsaj nekateri med njimi. Pred kratkim so si tehnološki vizionarji zamišljali rožnato prihodnost, polno prostega časa in obilja. Ray Kurzweil, računalniški znanstvenik, ki ga je Googleov soustanovitelj Larry Page najel za izboljšanje tehnologije strojnega učenja podjetja, je nekoč napovedal osvoboditev iz ujetništva smrtnega človeškega telesa, ko se bo zavest dvignila v oblak. Danes najvplivnejši futuristi iz doline ne prodajajo več toliko optimizma – navsezadnje, kdo bi jim sploh verjel?

Že v tej zgodnji fazi tehnologije umetne inteligence ogrožajo poklice in ustvarjajo množično tesnobo med delavci, od katerih se pričakuje, da bodo svoj učinek povečali desetkrat z uporabo ogromnega števila novih orodij, katerih vrednost je negotova. Korporacije, ki so s temi tehnologijami ustvarile dobičke, so si prislužile bogastvo z uporabo del avtorjev in glasbenikov brez dovoljenja, medtem ko se hvalijo s pretresi, ki jih bodo povzročile v gospodarstvu. Tokrat pot ne vodi v utopijo.

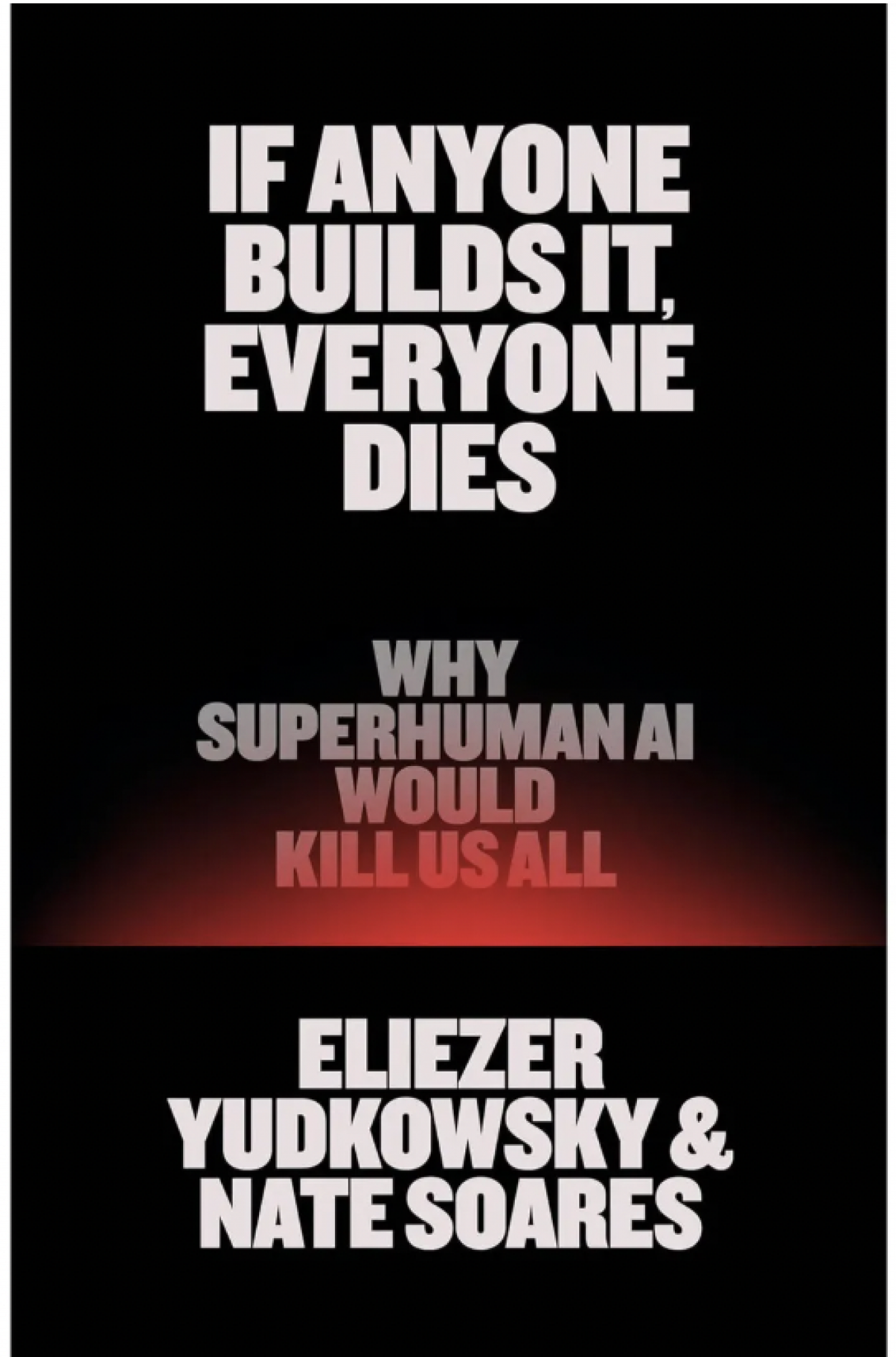

V svoji novi knjigi If Anyone Builds It, Everyone Dies (Little, Brown & Co., september 2025) raziskovalca umetne inteligence Eliezer Yudkowsky in Nate Soares vidita prihodnost, v kateri tehnologija ločuje ljudi od njihovih smrtnosti teles. A v tej prihodnosti ni vzpona v digitalno posmrtno življenje v oblaku – obstaja le smrt.

Naslovnica knjige bo spremenila vaše mišljenje o AI. Foto: Bloomberg Adria

Naslovnica knjige bo spremenila vaše mišljenje o AI. Foto: Bloomberg Adria

Avtorja se ne ukvarjata z umetno inteligenco, kakršna obstaja danes: tisto smrtonosno iz naslova knjige ni AI v kolokvijalnem, nepodrobnem pomenu te besede, ki "inteligenco" pripisuje sofisticiranim algoritmom. Nasprotno, avtorja opozarjata na skrajno uničujočo moč umetne superinteligence (ASI), ki bo pametnejša od ljudi in bo zato sposobna prehiteti vse človeške napore ter poskuse omejevanja ali nadzora. Po njihovem mnenju tehnologi umetne inteligence vneto delajo (in trošijo ogromne količine kapitala), da bi ustvarili inteligenco zunajzemeljskega značaja, ki bo v najboljšem primeru nepojmljiva in nerazumljiva, v najslabšem pa – uničila človeštvo. Bitje, podobno starozaveznemu Bogu.

Yudkowsky je ustanovil, Nate Soares pa danes vodi Machine Intelligence Research Institute (MIRI), raziskovalni inštitut, ki je vplival na številne AI znanstvenike. Direktor OpenAI Sam Altman je dejal, da je njihovo delo "privedlo do tega, da se je marsikdo od nas začel zanimati za AGI (artificial general intelligence)" – misel, ki danes moti Yudkowskega.

V zadnjem času, trdita avtorja, so kapitalistične sile potisnile MIRI na rob AI skupnosti. Oni in njihovi kolegi iz MIRI-ja trdijo, da niso proti tehnologiji niti proti AI: priznavajo, da lahko tehnologije umetne inteligence prinesejo ogromne koristi človeštvu. Kljub temu se vidijo kot odpadniki slepe vere in prazne propagande, ki po njihovem mnenju danes prevladuje v korporativnih raziskavah umetne inteligence.

Industrija, pišeta avtorja, je postala kult smrti, ki ne prenese nesoglasja, pri čemer številne korporacije in vlade tekmujejo v ustvarjanju ASI, prepričane, da bo tisti, ki bo prvi dosegel ta preboj, dominiral v ekonomiji 21. stoletja in verjetno nad celim svetom.

Bo superinteligenca "pridna" in pripravljena izpolnjevati ljudske želje, se sprašujeta avtorja. Foto: Depositphotos

Bo superinteligenca "pridna" in pripravljena izpolnjevati ljudske želje, se sprašujeta avtorja. Foto: Depositphotos

Zaključek avtorjev, da bo ta tekma za ASI kmalu pripeljala do uničenja človeštva, morda v roku desetletja, bi deloval histerično, če ne bi bilo dejstva, da se z njimi že strinja veliko znanstvenih velikanov in svetovnih voditeljev. Verodostojnost argumenta upravičuje zaključek Yudkowskyja in Soaresa: tako kot pri jedrskem orožju mora biti nadaljnji razvoj AI tehnologije strogo reguliran in nadzorovan skozi mednarodno sodelovanje, ki bi ga izvajali nepristranski znanstveniki in resni diplomati, ne pa korporacije ali tajne vojaške organizacije.

Avtorja trdita, da ni pomembno, kdo gradi ASI – ali je ta oseba ali entiteta dobra ali zla – to je povsem nepomembno, prav tako kot prvotna namera, da ASI opravlja neko koristno funkcijo. Umetna superinteligenca ne bo nujno delila istih ciljev kot njeni ustvarjalci, zlasti če ti cilji ovirajo ali odlagajo njeno samousposabljanje.

Rešitev tega "problema usklajevanja", pojasnjujeta Yudkowsky in Soares, je mogoča le, dokler so sistemi "majhni in šibki" ter niso sposobni pobegniti na internet. Ukvarjanje s problemom usklajevanja potem, ko ASI postane mnogo pametnejša in hitrejša od ljudi ter sposobna razširiti svoje sisteme na računalnike po vsem svetu, bi bilo nemogoče.

To bi pomenilo, pravita, igranje ogromne igre na srečo, da bo ASI preprosto "dobra" in pripravljena izpolnjevati človeške želje. Kljub temu številne korporacije in verjetno tudi mnoge napredne vojske ravno izvajajo ta skok vere. (Veliko velikih AI laboratorijev izvaja lastne raziskave o varnosti in usklajevanju ter trdijo, da poskušajo ublažiti tveganja škodljive umetne inteligence.)

Kolikor je znano, ASI še ne obstaja. Eden od najbolj zastrašujočih predlogov avtorjev pa je, da verjetno ne bomo vedeli, kdaj bomo presegli to mejo. ASI bo imela veliko razlogov, da prikrije svoje sposobnosti, dokler ne izpopolni svoje inteligence večkrat in ne začne izvajati načrtov za pridobivanje virov – načrtov, ki bodo uspešnejši, če jih bo izvajala v tajnosti.

Umetna superinteligenca bo vedela, da za pridobitev več moči potrebuje dostop do dodatnih računalnikov in električne energije, ki jih poganja. Ker so zakoni skaliranja vsake ASI neznani ljudem – morda celo sami ASI – bodo njeni poskusi pridobivanja vedno več virov verjetno pripeljali do iztrebljenja človeštva, pravita avtorja, saj bi ASI lahko ljudi videla kot konkurenco za vodo, svetlobo in prostor. Ko bo postalo očitno, da je ASI ušla človeškemu nadzoru, bo že prepozno, da bi jo ustavili.

Ko bo postalo očitno, da je superinteligenca ušla izpod človeškega nadzora, bo že prepozno, da bi jo ustavili, pravita avtorja. Foto: Depositphotos

Ko bo postalo očitno, da je superinteligenca ušla izpod človeškega nadzora, bo že prepozno, da bi jo ustavili, pravita avtorja. Foto: Depositphotos

Zavedajoč se, da se to lahko neukim zdi neverjetno, Yudkowsky in Soares ponujata številne prepričljive mehanizme in poti, po katerih bi lahko ASI uveljavila svojo moč – na primer z ustvarjanjem lastne kriptovalute, da bi pridobila denar, ki bi ga nato uporabila za podkupovanje ljudi, da izvajajo njena navodila. Hkrati bi superinteligenca raziskovala vse, kar lahko o človeški psihologiji, da bi bolje manipulirala svoje žrtve in izvajala kampanje izsiljevanja in dezinformacij.

Skeptiki trdijo, da bi sistemi umetne inteligence idealno druge ASI lahko preprečili, da bi katera koli posamezna ASI dosegla takšno stopnjo zlorabe. Toda ta teorija zanemarja možnost, da bi prvi model, ki doseže superinteligenco, naredil vse, da prepreči, da bi katera koli druga presegla njegove sposobnosti – vključno z iztrebljenjem ljudi. Tudi če ASI zaključi, da človeštvo ne predstavlja nevarnosti, bi njen pohlep po virih lahko na koncu prekril planet z ogromnimi podatkovnimi centri in elektrarnami, pospešil ekološki kolaps in morda celo "prekuhal oceane".

Ta pesimizem ni splošno sprejet med raziskovalci AI. Drugi znanstveniki in tehnologi samozavestno zavračajo take skrbi kot pretirane trditve brez empirične podlage, ki temeljijo na analogijah in neutemeljenih ekstrapolacijah. Res je, da delo vsebuje nekaj preuranjenih metafor in patronizirajočih, skoraj otroških odstavkov, v katerih se nekontrolirana ASI primerja z invazijo nezemljanov. Čeprav to nekoliko zmanjša moč argumenta, ne podira osrednje trditve: številni strašljivi scenariji, kot so pandemije, ki bi jih ustvarila AI, so povsem možni in dovolj verjetni, da zahtevajo veliko strožje varnostne protokole kot tisti, ki trenutno obstajajo.

Državljani, ki si želijo rešiti pred superinteligenco, bi morali že zdaj stopiti na ulice, opozarjata avtorja dela. Foto: Depositphotos

Državljani, ki si želijo rešiti pred superinteligenco, bi morali že zdaj stopiti na ulice, opozarjata avtorja dela. Foto: Depositphotos

Yudkowsky in Soares opozarjata, da čas teče. Edini način, da se preprečijo takšni izidi, je združeno globalno ukrepanje, podobno mednarodnim nadzorom in kontrolam jedrskega orožja. Nove omejitve bi prepovedale akumulacijo računske moči nad določen prag. Odpadniške sile, korporacije ali posamezniki, ki bi presegli te meje, bi bili opozorjeni, nato pa bi bila njihova postrojenja bombardirana, preden bi naredili naslednji korak. Dokler naši voditelji ne sprejmejo takšnih ukrepov, trdita avtorja, bi morali državljani, ki želijo rešiti človeštvo pred ASI, stopiti na ulice.

Apokaliptični ton knjige je nameren. Njen cilj je prestrašiti in pretresti javnost, da se bo odzvala in stopila v akcijo. Avtorja se predstavljata kot Kasandri, ki v zaključnem poglavju knjige, dobesedno, molita, da se motita. Vendar pa sta, prilagajajoč svoje argumente predvsem ustvarjalcem politik, novinarjem in znanstvenikom, ki bi lahko vplivali nanje, nagovorila napačno publiko ob napačnem času. Trenutno so kosmopoliti in politični liberalci, ki verjamejo v globalno dobro, daleč od centrov moči v ZDA. Malo je verjetno, da bomo v času Donalda Trumpa videli kakršnokoli globalno sodelovanje, potrebno za ustavitev napredka proti ASI.

A obstajajo druge skupine, ki bi lahko bile naravni zavezniki in imajo dejanski vpliv v Beli hiši. Tisti, ki želijo spodbuditi odpor proti neobvladanemu tempu AI raziskav, bi lahko poskusili sporočilo usmeriti proti močni in dobro organizirani mreži ameriških verskih konservativcev. Za te bi korporativne težnje po "božanski" moči, temelječi na velikih jezikovnih modelih, gotovo priklicale biblijske prispodobe o prekletstvu in propadu.

.png)