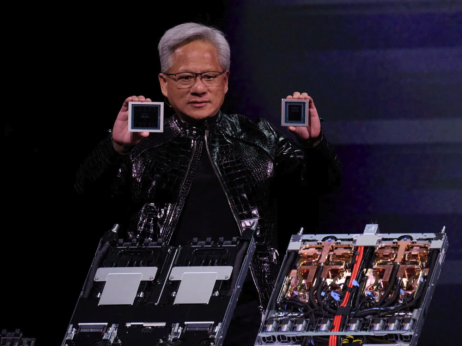

Ko Silicijeva dolina v začetku leta 2026 že tekmuje za prve dobave arhitekture Blackwell, novih Nvidia čipov, in ko se v industriji vse bolj odkrito govori o naslednji generaciji z imenom Rubin, je Kitajska dobila zeleno luč za nakup tehnologije, ki je Zahod ne šteje več za vrhunsko.

Dovoljenje za izvoz Nvidia H200 čipov na Kitajsko ni le tržna poteza v vrednosti več kot 40 milijard dolarjev, ampak hladno premišljena geopolitična odločitev: omogočiti Pekingu dostop do današnje infrastrukture, medtem ko mu jutrišnja ostaja nedosegljiva.

Kitajska podjetja so že naročila med 1,5 in 2 milijona H200 čipov – količino, ki večkrat presega letno proizvodnjo prejšnje generacije H100. Formalno gre za velik posel za Nvidio. V bistvu pa je to priznanje, da H200 v letu 2026 ni več "dragulj", ampak nova industrijska norma: dovolj zmogljiv, da poganja ekonomijo umetne inteligence, a premalo, da bi ogrozil tehnološko prednost, ki jo Zahod gradi z Blackwellom in bodočim Rubinom.

Za to odločitvijo se skriva še globlja ironija. Kitajska ne kupuje H200 le zato, ker ne more dobiti novejših čipov, ampak tudi zato, ker se Nvidiinem programsko-ekosistemu težko izogne. CUDA, Nvidiin programski okvir za GPU čipe, je postal de facto standard za razvoj umetne inteligence.

Ogromna večina obstoječih AI sistemov, orodij in knjižnic je napisana prav za CUDA okolje, zaradi česar je prehod na alternativni strojni sistem tehnično tvegan in ekonomsko drag. Tudi če bi kitajska podjetja razvila konkurenčen strojni sistem, programska odvisnost ostaja.

V tem kontekstu dovoljenje za izvoz H200 na Kitajsko ni znak šibkosti, ampak oblika nadzorovanega upočasnjevanja. Kitajska dobiva dostop do čipov, združljivih z ekosistemom CUDA, s čimer se še dodatno veže na Nvidiino programsko opremo, medtem ko ji najnovejše arhitekture ostajajo nedosegljive. To je vstopnica v tekmo, kjer je startna črta namerno premaknjena nazaj.

Do včeraj je bil H200 ekskluzivna infrastruktura, rezervirana za najnaprednejše laboratorije. Meta je trenirala modele Llama na desetine tisoč teh čipov hkrati, medtem ko so Google, Amazon in Microsoft kupovali vse, kar je Nvidia lahko dobavila.

Avtomobilska industrija jih je uporabljala za razvoj avtonomne vožnje, farmacevtska podjetja pa za simulacijo molekul novih zdravil. Danes isti H200 postaja "dovoljena" tehnologija za Kitajsko – ne zato, ker bi bil nepomemben, ampak zato, ker Zahod že gradi naslednjo stopnjo.

Kaj je H200 in zakaj ni običajen GPU

H200 je grafični procesor, zasnovan izključno za umetno inteligenco. Za razliko od GPU čipov v prenosnikih, katerih osnovna naloga je prikazovanje grafike v video igrah ali predvajanje videoposnetkov, H200 ne "riše slik". Izvaja matematične operacije – milijarde hkrati.

Fizično je H200 velik približno kot knjiga, medtem ko je klasičen GPU velikosti poštne znamke. Razlika v pomnilniku je še bolj dramatična: tipičen gaming GPU ima okoli 16 GB pomnilnika, H200 pa razpolaga s 141 GB ultra-hitrega pomnilnika. V praksi to pomeni, da H200 lahko hrani in obdeluje ogromne AI modele neposredno v pomnilniku, brez stalnega prenašanja podatkov.

Glede moči je H200 do stokrat zmogljivejši od najmočnejših gaming GPU čipov pri nalogah, povezanih z umetno inteligenco. Prav ta razlika določa mejo med "AI aplikacijo" in "AI infrastrukturo".

Zakaj svet ne more proizvesti dovolj H200 čipov

Nvidia sama ne proizvaja H200. Ta čip gre skozi desetine tovarn na treh kontinentih. Tajvanski TSMC proizvaja sam procesor in ga integrira s pomnilnikom. Južnokorejska podjetja SK Hynix in Micron proizvajajo HBM pomnilnik – specializiran ultra-hiter pomnilnik, brez katerega sodobni AI čipi ne morejo delovati. Japonska podjetja dobavljajo ključne substrate.

Ozko grlo celotnega sistema je TSMC-jeva CoWoS tehnologija pakiranja, proces, ki združi procesor in pomnilnik v eno celoto. Nvidia je rezervirala več kot polovico globalnih CoWoS zmogljivosti do leta 2027, kar pomeni, da AMD, Intel in tudi oblačni giganti z lastnimi čipi delijo preostanek.

Razlog, zakaj je CoWoS ključnega pomena, je hitrost. V klasičnih GPU sistemih sta procesor in pomnilnik povezana preko matične plošče, z žicami, ki fizično omejujejo tok podatkov. Pri H200 sta pomnilnik in procesor na isti podlagi. Razlika je kot med pošiljanjem pisma po pošti in predajanjem informacij iz roke v roko. V svetu umetne inteligence se ta razlika meri v desetkrat hitrejšem dostopu do podatkov – kar neposredno vpliva na sposobnost treniranja velikih modelov.

V letih 2026 in 2027 trga več ne pestijo pomanjkanja, kot je bilo leta 2024, a dobavna veriga ostaja krhka. Vsak motnji, od geopolitičnih napetosti do naravnih nesreč v Aziji, lahko ustavi dobave in upočasni celotno industrijo.

Kar zadeva druge konkurente na trgu, AMD poskuša s čipom MI300X, ki ima 192 GB pomnilnika, medtem ko Google, Amazon in Microsoft razvijajo lastne čipe. Googleov TPU je primeren za lastne modele, vendar ni univerzalen, prav tako ne Amazonov Trainium. Situacija je podobna Intelovi dominaciji na trgu PC procesorjev v devetdesetih – vsi vedo, da monopol ni zdrav, a nihče nima boljše alternative.

Regija Adria: kje so naši čipi?

Medtem ko globalni giganti vlagajo desetine milijard dolarjev v lastno AI-infrastrukturo, se regija Adria zanaša na starejše generacije čipov in oblačne storitve. Telekom Srbija ima GPU-klaster v Beogradu, ki temelji na Nvidia A100 čipih, predhodnikih H100 in H200. Podobne konfiguracije obstajajo tudi v Zagrebu in Ljubljani.

Argument je vedno isti: cena. En strežnik z osmimi H200 čipi stane toliko kot trisobno stanovanje v središču Beograda (približno 350.000 evrov). Za večino regionalnih podjetij je to nedosegljiva investicija, zato se računalniška moč najema od globalnih ponudnikov oblačnih storitev.

Vprašanje pa je, ali je to dolgoročno vzdržna strategija. Če se regija trajno odpove lastni infrastrukturi in se zadovolji z vlogo uporabnika tujih modelov, tvega, da ostane le trg, ne pa proizvajalec vrednosti. Čipi A100 so sicer dovolj za chatbote in analitiko, niso pa temelj za treniranje modelov, ki oblikujejo novo ekonomijo.

Brez lastne infrastrukture regija Adria tvega, da postane digitalna kolonija, ki plačuje najemnino za tujo infrastrukturo.

Čipi ozko grlo za novi slovenski superračunalnikSlovenija naj bi do konca leta po načrtih v Mariboru zagnala novi superračunalniški center, v katerem bo delovala 'tovarna umetne inteligence'. Potrebni bodo zmogljivi čipi, že na lani konferenci Bloomberg Adria Future Fusion Summit pa je direktor Instituta informacijskih znanosti (Izum) Aleš Bošnjak izpostavil izziv: "Največja neznanka je dobava sestavnih delov za Vego 2." "Nabava najbolj zmogljivih GPU za tovarno umetne inteligence sama po sebi prinaša precej tveganj, ker se razmere na trgu in geopolitične razmere stalno spreminjajo," je za Bloomberg Adria komentiral Marko Grobelnik, sodelavec v laboratoriju za umetno inteligenco (UI) na Inštitutu Jožefa Stefana. Dobavitelji so namreč odvisni od proizvajalcev, proizvajalci pa so odvisni od dnevne geopolitike in podizvajalcev, pravi Grobelnik. Opozarja tudi, da se sodelavci pri slovenskem projektu superračunalnika zavedajo, da nimajo vpliva na celoten proces nabave, "tako kot ga nima nihče drug". Superračunalnik bo stal 150 milijonov evrov. Več o njem na povezavi. (A. L.) |

.png)